- Maandag op WWDC kondigde Apple vakkundig aan hoeveel werk het bezig was met de nieuwste AI- en machine learning-technologieën.

- In tegenstelling tot de meeste door AI aangedreven technologiebedrijven, voert Apple geavanceerde verwerking uit op zijn apparaten in plaats van te vertrouwen op de cloud.

- In plaats van te praten over AI-modellen en -technologieën, betekent de focus op een Apple-product dat het meestal gewoon pronkt met nieuwe functies die stilletjes door AI achter de schermen worden mogelijk gemaakt.

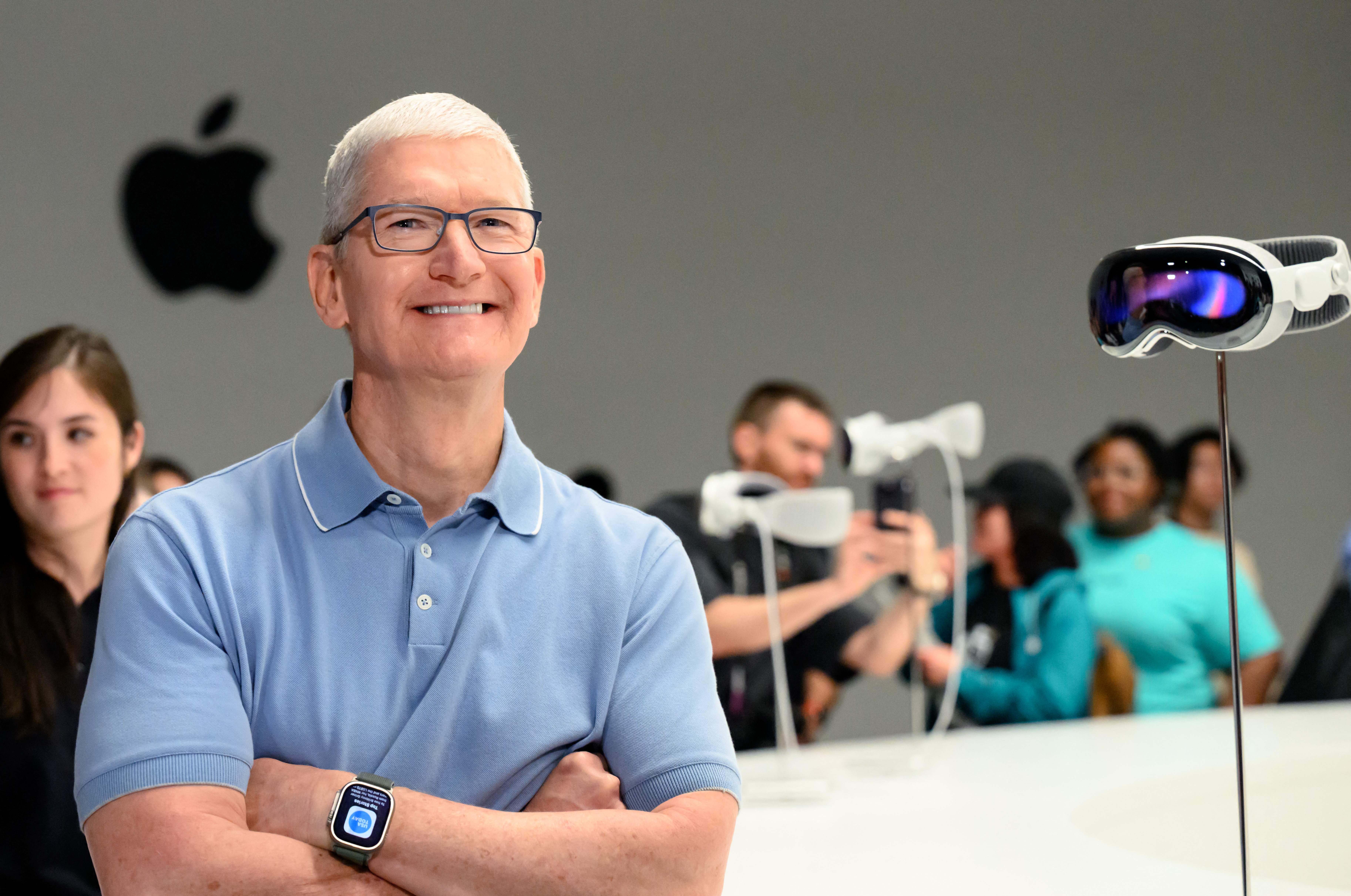

Apple Park wordt gezien voorafgaand aan de Worldwide Developers Conference (WWDC) in Cupertino, Californië, op 5 juni 2023.

Jos Adelson | AFP | Getty-afbeeldingen

Maandag tijdens de jaarlijkse WWDC-ontwikkelaarsconferentie van Apple onthulde het bedrijf hoeveel werk het doet aan de nieuwste AI- en machine learning-technologieën.

Terwijl Microsoft, Google en startups zoals OpenAI geavanceerde machine learning-technologieën zoals chatbots en generatieve AI omarmden, leek Apple aan de zijlijn te blijven staan.

Maar op maandag kondigde Apple verschillende belangrijke AI-functies aan, waaronder iPhone-autocorrectie op basis van machine learning-software met behulp van een adaptertaalmodel, dezelfde technologie die ten grondslag ligt aan ChatGPT. Apple zei dat het zelfs zal leren van hoe de gebruiker scripts en typen doet om te verbeteren.

Craig Federighi, Chief Software Officer van Apple, maakte grapjes over de neiging van AutoCorrect om het onzinnige woord “ducking” te gebruiken om een veelvoorkomende krachtterm te vervangen.

Het grootste nieuws van maandag was de coole nieuwe augmented reality-headset, de Vision Pro, maar Apple liet niettemin zien hoe het werkt en is geïnteresseerd in de nieuwste ontwikkelingen op het gebied van machine learning en kunstmatige intelligentie-technologie. OpenAI’s ChatGPT heeft misschien meer dan 100 miljoen gebruikers bereikt in twee maanden toen het vorig jaar werd gelanceerd, maar Apple gebruikt nu de technologie om een functie te verbeteren die dagelijks door 1 miljard iPhone-bezitters wordt gebruikt.

In tegenstelling tot zijn concurrenten, die grotere modellen bouwen met serverfarms, supercomputers en terabytes aan data, wil Apple AI-modellen op zijn apparaten. De nieuwe autocorrectiefunctie is vooral indrukwekkend omdat deze werkt op de iPhone, terwijl modellen zoals ChatGPT honderden dure GPU’s nodig hebben die samenwerken.

AI op het apparaat omzeilt veel van de problemen met gegevensprivacy waarmee cloudgebaseerde AI te maken heeft. Wanneer een model op een telefoon kan worden uitgevoerd, hoeft Apple minder gegevens te verzamelen om het uit te voeren.

Het hangt ook nauw samen met de controle van Apple over zijn hardwareportfolio, tot en met zijn siliciumchips. Apple bouwt elk jaar nieuwe AI-circuits en GPU’s in zijn chips en dankzij de controle over de algehele architectuur kan het bedrijf zich aanpassen aan veranderingen en nieuwe technologieën.

Apple praat niet graag over “kunstmatige intelligentie” – ze geven de voorkeur aan de academische uitdrukking “machine learning” of praten gewoon over het voordeel dat de technologie mogelijk maakt.

Sommige van de andere toonaangevende AI-bedrijven hebben leiders met een academische achtergrond. Dit heeft ertoe geleid dat u zich concentreert op het tonen van uw werk, uitleggen hoe het in de toekomst kan verbeteren en het documenteren zodat anderen het kunnen bestuderen en erop kunnen voortbouwen.

Apple is een productbedrijf en het is al tientallen jaren erg geheimzinnig. In plaats van te praten over het specifieke AI-model, de trainingsgegevens of hoe het in de toekomst zou kunnen verbeteren, vermeldt Apple gewoon de functie en zegt dat er achter de schermen geweldige technologie aan het werk is.

Een voorbeeld hiervan op maandag is een AirPods Pro-verbetering die ruisonderdrukking automatisch uitschakelt wanneer een gebruiker in gesprek is. Apple heeft het niet ingekaderd als een machine learning-functie, maar het is moeilijk op te lossen en de oplossing is gebaseerd op kunstmatige-intelligentiemodellen.

In een van de brutaalste functies die maandag is aangekondigd, scant de nieuwe Digital Persona-functie van Apple het gezicht en lichaam van een gebruiker in 3D, zodat het virtueel kan nabootsen hoe je eruit ziet tijdens videoconferenties met andere mensen terwijl je een Vision-headset draagt.

Apple noemde ook verschillende andere nieuwe functies die gebruik maakten van de vaardigheid van het bedrijf op het gebied van neurale netwerken, zoals de mogelijkheid om velden te selecteren om een pdf in te vullen.

Een van de grootste gejuich van de middag in Cupertino was de machine learning-functie waarmee de iPhone je huisdier kan herkennen – in tegenstelling tot andere katten of honden – en alle huisdierfoto’s van een gebruiker in een map kan stoppen.

‘Reader. Furious humble travel enthusiast. Extreme food scientist. Writer. Communicator.’